نحوه ساخت فایل robots.txt مطلوب سئو

برای ساخت یک فایل robots.txt بهینه که موجب بهبود سئو شود ابتدا باید شناخت کاملی از این فایل و عملکرد آن داشته باشیم. به همین منظور ابتدا مجموعه دستوراتی که در قالب فایل robots.txt ارائه می شود را بررسی می کنیم و سپس با توضیح مهم ترین دستورات ، نقش و تاثیر آن در سئو و رتبه بندی سایت را بیان می نماییم. Robots.txt یک سری از دستورات قابل فهم برای موتورهای جستجو است که از آنها می خواهد چگونه یک وبسایت را بررسی و ایندکس کنند و علی رغم حجم کم و چند کیلوبایتی که دارد ، کارکرد خارق العاده ای در عملکرد و وضعیت سایت در نتایج serp خواهد داشت.

از مزایای این فایل دستوری می توان به افزایش امنیت سایت ، بهبود رتبه ، افزایش بازدید سایت و ارتقای سئوی سایت اشاره کرد.

فایل robots.txt چیست؟

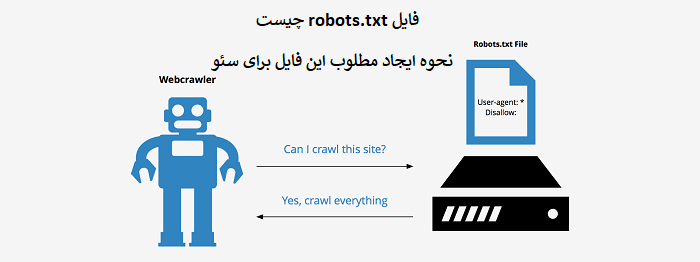

فایل robots.txt یک فایل با فرمت text است که شامل دستوراتی جهت دسترسی یا عدم دسترسی موتورهای جستجو به یک یا تعدادی از صفحات و زیردامنه های وبسایت می شود. گوگل ، بینگ ، یاهو و بسیاری دیگر از موتورهای جستجو جهت بررسی و رتبه بندی سایت ها خزنده ها یا ربات هایی را طراحی کرده اند که تک تک صفحات ، جملات و عبارات و لینک های موجود در یک دامنه را آنالیز می کنند و بر مبنای ضوابط خاص هر موتور جستجو رتبه بندی خواهند کرد.

در این شرایط ضروری است که برای افزایش دامین اتوریتی فقط صفحات و مطالب باکیفیت و مهم دیده شوند و صفحاتی که بی ارزش و با محتوای ضعیف هستند نه بررسی شوند و نه ایندکس! اما ربات ها هر صفحه ای را که دوست داشته باشند گزارش می کنند و برای جلوگیری از این اتفاق باید شما دستوراتی را تعریف کنید که اختیارات و میزان دسترسی خزنده های موتورهای جستجو به سایت خود را محدود و هدفمند نمایید. چاره این کار ایجاد یک فایل robots.txt دقیق و مطلوب است. برای مثال هیچ فردی علاقه ندارد که صفحه مدیریت سایت ( ادمین ) در نتایج جستجو ظاهر شود زیرا می تواند موجب سو استفاده هکرها قرار گرفته و مخرب باشد ، پس باید به کمک robots.txt این بخش را پنهان کنید.

نقش robots.txt در سئو

این فایل شدیدا در سئو برای موتورهای جستجو اهمیت دارد و اگر در سرچ کنسول گوگل دقت کرده باشید یک بخش مجزا و اختصاصی برای ثبت و تست robots.txt قرار داده شده است و بسیاری از افزونه های مهم وردپرس مانند yoast seo نیز نگاه ویژه ای به آن دارند. این دستورات به قدری مهم و موثر هستند که در صورت تنظیمات صحیح ، ارتقا سایت را به دنبال داشته باشند و با اعمال اشتباه دستورات بعضا حذف کل سایت از موتور جستجو را به همراه دارند. این تصمیم شماست که چه دسترسی و مجوزهایی را به خزنده ها بدهید پس در بارگزاری آن بر روی هاست خود نهایت دقت را داشته باشید.

نقشی که robots.txt در فرآیند سئو ایفا می کند مربوط به کنترل دیده یا پنهان شدن صفحات سایت است و جهت ایجاد یک فایل مطلوب که در سئو تاثیر مثبتی داشته باشد باید تمام صفحات وبسایت خود را تحلیل کنید و براساس اهمیتی که دارند اولویت بندی نمایید. صفحات بدون محتوا را از دسترس ربات ها خارج کنید و پیج هایی مثل ناحیه ادمین که نیازمند امنیت بالایی است را دور از دست کاربران دیگر و موتورهای جستجو قرار دهید. همچنین با این فایل می توان دسترسی به افزونه هایی که عملا تاثیر مثبتی در رتبه سایت ندارند را نیز محدود کرد.

ایجاد فایل robots.txt مطلوب

چگونگی ایجاد مطلوب این دستورات با دقت به تاثیر مثبت در سئو اهمیت زیادی دارد. معمولا در بسیاری از سایت ها robots.txt بصورت پیش فرض تعریف شده و براساس دستورات زیر می باشد:

*:user-agent

/Disallow: /wp-admin

که ساده ترین حالت مطلوب برای این فایل می باشد. عبارت user-agent نوع موتور جستجو ( گوگل ، یاهو و… ) را مشخص می کند و زمانی که علامت ستاره در جلوی آن قرار می گیرد یعنی دستورات برای تمام خزنده های موتورهای جستجو اعمال شود.

اگر بخواهید دستورات فقط برای یک موتور جستجوی مشخص اعمال شود به جای * باید نام خزنده مربوط به همان جستجوگر را تایپ کنید. مانند مثال زیر که دستورات را فقط برای گوگل اجرا خواهد کرد:

User- agent: googlebot

اولین دستور در این فایل disallow یا عدم دسترسی ربات ها به ناحیه مدیریت ادمین سایت را تعریف می کند. اما این تمام ماجرا نیست و باتوجه به تعداد صفحات ، نوع سایت ، زبان برنامه نویسی ، محتوا و مطالب فایل robots.txt می تواند دستورات و شرایط متفاوتی داشته باشد.

allow یا disallow تصمیم با شماست

در مجموع به هر صفحه ای که می خواهید دسترسی دهید از allow استفاده کنید و با دستور disallow اجازه دسترسی ربات جستجوگر را منع کنید.

برای مثال دستورات زیر را در نظر بگیرید:

*:user-agent

/:Disallow

این دستور دسترسی تمام موتورهای جستجو به کل دامنه را قطع می کند و عملا سایت به هیچ وجه در نتایج serp ظاهر نخواهد شد و عملکرد آن را دچار نقص می نماید.

درج آدرس نقشه سایت

یکی دیگر از مواردی که در این فایل می تواند قرار بگیرد ، آدرس نقشه سایت است که رباتها را متوجه سایت مپ و ارتباط سریعتر با صفحات می کند. که به صورت دستور sitemap:https://yourdomain.com/sitemap.xml می توان آن را ثبت کرد.

فایل robots.txt باید در پوشه اصلی هاست شما بارگزاری شود که البته اگر از وردپرس استفاده می کنید ، با نصب افزونه یوست سئو می توانید خیلی راحت از ناحیه مدیریت وردپرس این سایت را تعریف و آپلود نمایید.

ابزار ساخت robots.txt به شما کمک میکند با کمترین دانش در این زمینه، یک فایل مناسب و بهینه برای بارگزاری در سایت تولید کنید.

دیدگاه خود را ثبت کنید

تمایل دارید در گفتگوها شرکت کنید؟در گفتگو ها شرکت کنید.